|

DOI: 10.7256/2306-4196.2016.1.17770

Received:

29-01-2016

Published:

11-02-2016

Abstract:

The subjects of the research are techniques for combining sensory and synthesized video information in appliance to the aviation system of combined vision. The use of such systems allows controlling manned and unmanned aerial vehicles under conditions of low visibility by combining video information from on-board camera with video data synthesized by a priori given virtual model of a terrain. It is known that on-board navigation system measuring the position and orientation of the aircraft has accuracy errors because of which the angle of the synthesized image on a virtual model of the area does not match the foreshortening of shooting onboard cameras. This is why a procedure for combining sensory and synthesized video information in the aviation system of combined vision is needed. The study was conducted with the use of mathematical and computer modeling of combined vision systems using both synthesized and real images of an underlying terrain. The novelty of these results lies in the universality of the developed algorithm. This algorithm allows combining video content with an arbitrary data along with the possibility of its practical implementation and high quality combining. Developed algorithm for combining sensory and synthesized video information on the basis of typological binding and Kalman filtering provides a sufficiently precise and reliable combining that meets the minimum requirements for the aircraft systems combined vision. The algorithm is universal, has low demands to the scene recorded images, has low computational complexity and can be implemented in hardware and software based on modern avionics. When testing the algorithm the authors used precision characteristics at the level of consumer navigation devices which significantly inferior in accuracy compared to modern air navigation systems. This indicates the possibility of using the algorithm in inexpensive and compact user systems, as well as in mobile robots.

Keywords:

algorithms, vision systems, a virtual reality, combining images, virtual model of the terrain, man-machine interfaces, aviation systems, airborne avionics, combined vision systems, synthesized vision system

This article written in Russian. You can find original text of the article here

.

Введение Информированность экипажа воздушного судна или оператора беспилотного летательного аппарата (ЛА) в плохих условиях видимости в различных фазах полёта, особенно при заходе на посадку и посадке по-прежнему остаётся важной задачей обеспечения безопасности полётов. Согласно исследованиям Всемирного фонда безопасности, почти 75% аварий самолётов при заходе на посадку и посадке происходят в аэропортах, где недоступны или отсутствуют приборы точного захода на посадку, в условиях плохой видимости [3]. Поэтому с ростом производительности бортовых вычислителей, обрабатывающих визуальную информацию (в том числе и трёхмерную графику) одним из актуальных и динамично развивающихся направлений совершенствования бортовой авионики стало создание систем непрерывного визуального представления внешнего пространства. К таким системам относят авиационные бортовые системы комбинированного видения (СКВ), представляющие собой совокупность систем синтезированного (искусственного) видения (ССВ) и улучшенного (усиленного) видения (СУВ). Применение СКВ позволит производить управление пилотируемых и беспилотных ЛА в условиях недостаточной видимости за счёт объединения видеоинформации от бортовых видеодатчиков с видеоинформацией, синтезированной по виртуальной модели местности (ВММ), исходя из текущих значений положения и ориентации ЛА. Однако бортовая навигационная система (НС), измеряющая положение и ориентацию ЛА, имеет погрешности, из-за которых ракурс изображения ВММ, синтезируемого виртуальным датчиком, не соответствует ракурсу съёмки бортовыми видеодатчиками, поэтому необходима процедура совмещения, сенсорного и синтезированного изображений.

Согласно руководству № 315 [14] (далее Р‑315) и DO-315B [18], СКВ используются для обеспечения ситуационной информированности пилотов и могут формировать искусственные изображения подстилающей поверхности в комбинации с изображениями от бортового сенсора, наложенными и согласованными друг с другом на одном дисплее. При этом СКВ должна обеспечивать частоту обновления кадров ≥ 15 Гц, что накладывает довольно жёсткие ограничения на производимый объём вычислений алгоритмами, обеспечивающих её работу. Краткий обзор методов совмещения видеоинформации в СКВ Известные зарубежные и отечественные методы совмещения изображений для СКВ имеют недостатки, не позволяющие эффективно их применять.

Подход компании Honeywell [16] использует нелинейную трансформацию плоских цифровых изображений без использования модели их формирования, что даёт низкую точность совмещения за счёт использования только двух точек, принадлежащих различным топологическим особенностям (ТО). Под ТО понимаются области изображения с перепадами яркости, образующими характерные фигуры, например, область пересечения дорог, горный пик, изгиб реки, угол здания и т. д.

В методе [7] требуется наличие однозначно распознаваемой взлётно-посадочной полосы (ВПП). Но надёжное (на расстоянии не менее 1,5–2 км до зоны касания ВПП) автоматическое распознавание ВПП по сенсорным изображениям подстилающей поверхности может быть реализовано в простых или близким к таковым метеоусловиям, когда возможен режим визуального пилотирования. Поэтому данный способ имеет весьма ограниченные условия применения. При существенном изменении входных данных (вместо ВПП – круглая вертолётная площадка), алгоритм распознавания придётся модифицировать, что также не в пользу его универсальности.

Метод совмещения [5] может работать с произвольными сюжетами, однако имеет высокую вычислительную трудоёмкость на этапе получения по ВММ ракурса, отвечающего ракурсу сенсорного кадра. Уточнение состоит в полном переборе шести параметров внешнего ориентирования с постоянным или переменным шагом внутри выпуклого компакта, где область поиска ограничена известными погрешностями бортовой НС. Сложность уточнения оценивается как 106·N операций, где N – число пикселей совмещаемых изображений, что говорит о невозможности его реализации на современных бортовых вычислителях, что ранее отмечалось в статье [1] в разделе «Существование решения задачи совмещения».

Предлагаемый алгоритм лишён указанных выше недостатков за счёт использования ВММ не только для получения и формирования синтезированных изображений по уточнённым данным, но и для автоматического извлечения центров предварительно известных ТО на них для осуществления привязки. Выбранный подход требует ввод априорной информации в ВММ о том, какие точки в пространстве ВММ следует считать центрами особенностей, годными для привязки. Однако это не ограничивает универсальность применения, поскольку любые ВММ, используемые в современных авиационных системах (например, в ССВ), создаются вручную на основании реальных измерений и данных космической или аэрофотосъёмки. Следовательно, без потери общности и универсальности подхода предварительный выбор центров наиболее значимых ориентиров в ВММ также задаётся вручную. Исходные данные для алгоритма совмещения сенсорной и синтезированной видеоинформации Для работы предлагаемого ниже алгоритма совмещения необходима следующая информация:

1) изображение, сформированное бортовым оптико-электронным сенсором (БОЭС) или СУВ (в этом случае входное изображение может представлять собой результат комплексирования изображений от нескольких БОЭС разных спектральных диапазонов);

2) текущие координаты и углы ориентации ЛА, получаемые от бортовой НС с неизбежными ошибками;

3) значения допустимых погрешностей (ошибок) НС, измеряющей координаты и угловую ориентацию ЛА;

4) достоверная ВММ (с желательным, но необязательным наличием фототекстур на основе космических или аэрофотоснимков);

5) модель формирования синтетического изображения на основании ВММ;

6) характеристики бортовых видеосенсоров: угловые размеры полей зрения и пиксельные размеры формируемых изображений;

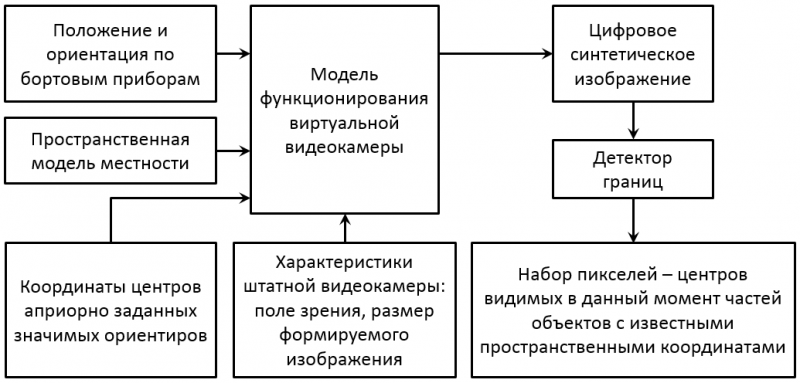

7) набор координат центров ТО в пространстве ВММ. Формирование синтезированного изображения Модель функционирования виртуальной видеокамеры представляет собой матричное преобразование ВММ [8], последовательное произведение матрицы сдвига с матрицей поворота по трём углам ориентации в пространстве и с матрицей перспективного проецирования. Его параметры – угловые размеры поля зрения, разрешение в эффективных пикселях, а также положение и ориентация бортового видеодатчика. При умножении вершин и их атрибутов из ВММ на данную матрицу с размерами области вывода, идентичными размерам сенсорного изображения, получают синтезированное изображение. Автоматическое отождествление топологических особенностей на сенсорных и синтезированных изображениях Чтобы не принимать за ТО на сенсорном кадре особенность, быстро меняющуюся во времени (например, движущийся транспорт) или заведомо отсутствующую в ВММ (например, край облака), будем считать эталонными области синтезированного изображения. Кроме того, на синтезированных изображениях практически нет шумов и помех. При этом возможно автоматически извлекать одни и те же ТО для любых параметров виртуальной камеры. В предлагаемом алгоритме меньше этапов распознавания, чем в выше отмеченных, что делает его более надёжным.

Координаты центра ТО в ВММ могут лежать на грани объекта или на его вершинах. Поэтому производится проверка их видимости. Все невидимые точки в области кадра следует исключить с помощью, например, детектора границ. Эффективный результат даёт оператор Собеля [10]. На рис. 1 приведена схема получения центров ТО.

Рис. 1. Схема автоматического получения центров ТО для синтетического изображения

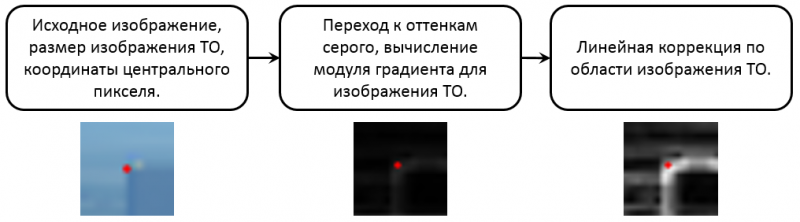

После получения центров ТО необходимо получить эталонные изображения локальных особенностей (изображения ТО, ИТО) на синтезированном кадре. Квадратные ИТО формируются вокруг центров ТО на кадрах, переведённых в оттенки серого, вычисляется модуль градиента с помощью оператора Собеля и производится линейная коррекция яркости, см.: рис. 2. Размер ИТО порядка 20 х 20 пикселей даёт достаточную устойчивость к шуму и дискретизации, а также позволяет с достаточной устойчивость сравнивать ИТО частей сцены, находящихся в различных ракурсах. Использование модуля градиента монохромного изображения обеспечивает инвариантность к цветовым и яркостным составляющим.

Рис. 2. Способ формирования изображения ТО (угол здания)

Далее на сенсорном изображении выделяются области поиска ТО. Их центры соответствуют центрам ТО на синтезированном изображении, а размеры определяются погрешностями бортовой НС. Целесообразно использовать размеры, превышающие размеры ИТО. Для каждой ТО на синтезированном кадре ищут ей соответствующую ТО равного размера на сенсорном. Внутри области поиска формируются всевозможные ИТО и вычисляется мера их отклонения от эталонного ИТО. Критерий поиска определяется выражением:

`D = sum_(x=0)^(N-1)sum_(y=0)^(N-1)[L_(R)(x,y) - L_(S)(x,y)]^2,` (1)

где N – линейный размер по ширине и высоте сопоставляемых ИТО, LR(x, y) и LS(x, y) – яркости пикселей на сенсорном R и синтезированном S ИТО.

Иногда искомая ТО может отсутствовать на сенсорном изображении. Так как в локальной области поиска минимум различия между ИТО всегда существует, то он должен быть достаточно выраженным. Надёжный результат даёт адаптивное условие, зависящее от значения (1) в фиксированной области поиска K:

`min_(K)D < 0.25*max_(K)D.` (2)

При выполнении условия (2) искомая ТО учитывается на этапе уточнения местоположения и ориентации виртуальной камеры. Величина весового коэффициента порога в формуле (2) получена эмпирически.

На рис. 3 представлен пример отождествления ТО на инфракрасных (ИК) сенсорных и синтезированных изображениях.

Рис. 3. Пример топологического отождествления для разнородных изображений Уточнение положения и ориентации виртуальной камеры Уточнённые параметры виртуальной камеры: положение (x, y, z) и углы ориентации (ψ, θ, γ) – курс, тангаж и крен соответственно находятся путём минимизации функции невязки расстояний между центрами соответствующих ТО. Функция невязки S(x, y, z, ψ, θ, γ) может быть задана, как функция от суммы квадратов расстояний между соответствующими пикселями изображений:

`S(x,y,z,psi,theta,gamma)=sum_(i=1)^N[(Q_(i).X - P_(i).X)^2+(Q_(i).Y - P_(i).Y)^2] +delta^2,` (3)

где (Qi.X, Qi.Y),– координаты центрального пикселя ТО найденной на сенсорном изображении; (Pi.X, Pi.Y), Pi = P{x, y, z, ψ, θ, γ, (Xi, Yi, Zi )}– координаты центрального пикселя соответствующей ТО на синтезированном изображении, полученные действием оператора перспективного проецирования P на точку (Xi, Yi, Zi ) в пространстве ВММ из положения и ориентации виртуальной камеры (x, y, z, ψ, θ, γ); N – число точек-центров ТО; δ = const ≠ 0 - для положительной определённости функции (3). Функция вида (3) хорошо себя зарекомендовала для поиска пар соответствующих пикселей в задаче формирования текстурированной ВММ с использованием лазерного дальномера и видеокамер, образующих стереопару [4].

Минимум функции S(x, y, z, ψ, θ, γ) ищется на компактном множестве

`K={x+-deltax, y+-deltay, z+-deltaz, psi+-deltapsi, theta+-deltatheta, gamma+-deltagamma},` (4)

где δx, δy, δz, δψ, δθ, δγ – известные максимальные погрешности бортовой НС. Его можно найти методом покоординатного спуска [11], что обосновано ниже.

Однозначность функции (3) гарантирует условие наличия не менее трёх ТО на изображении (N≥3), которые в ВММ не лежат на одной прямой. Функция (3) непрерывна в силу непрерывности оператора проецирования P и имеет положительно определённую квадратичную форму для любых (x, y, z, ψ, θ, γ). Тогда достигается единственный минимум функции (3) на множестве (4) методом покоординатного спуска, согласно теореме о его сходимости [11]. Покоординатные минимизации функции (4) могут производится, например, методом деления отрезка пополам [12]. Метод покоординатного спуска сходится линейно. Для сходимости требуется ≤ 5 итераций и на каждой итерации не нужно обрабатывать изображения, а только извлекать проекции уже известных ТО и вычислять целевую функцию (3).

В работах [1] и [7] предлагается уточнять параметры камеры путём минимизации невязок условий коллинеарности центра её проецирования, опорных точек на синтезированном изображении и соответствующих им точек на сенсорном. Однако при моделировании в динамике оказалось, что такой подход не гарантирует выдачу уточнённых показаний внутри множества (4) и более сложен в практической реализации.

Окончательно значения уточнённых параметров виртуальной камеры подаются в память бортового вычислителя, где синтезируется новое изображение для комплексирования с сенсорным кадром. Калмановская фильтрация для стабилизации синтезированного изображения В динамике меняется количество и структура расположения ИТО на паре совмещаемых кадров, что может приводить к резким скачкам и дрожаниям деталей комбинированного кадра. Для «сглаживания» эффективна одномерная фильтрация по Калману [15]. При временной фильтрации параметров виртуальной камеры предполагается их независимость друг от друга.

Для оценки положения допускается, что движение в течении n измерений равномерно и прямолинейно:

`x(t)=b_(0) + b_(1)t, t = bar(t_(0), t_(n-1)).` (5)

Для углов ориентации качественную фильтрацию обеспечивает гипотеза о гармоническом законе движения в течении m измерений:

`x(t)=b_(0) + b_(1)sin(ct)+b_(2)cos(ct), c=(pi)/(180),t=bar(t_(0),t_(m-1)).` (6)

Согласно независимости измерений НС имеем 6 одномерных фильтров Калмана.

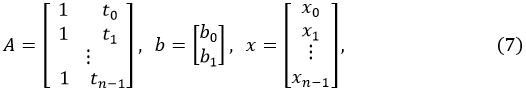

Для оценки положения ЛА фильтр имеет вид:

A – матрица аргументов гипотетического закона движения, b – вектор его коэффициентов, `x in {X,Y,Z}` – вектор измерений координаты.

Решаем систему `Ab=x` методом наименьших квадратов (МНК) [7]:

`hatb = (A^TA)^-1A^Tx,` ` ` (8)

тогда текущее отфильтрованное значение координаты х вычисляется как

`hatx_(n-1)=hatb_(0)+hatb_(1)t_(n-1).` (9)

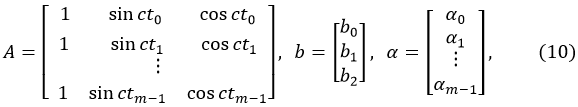

Для оценки углов ориентации ЛА фильтр имеет вид:

A – матрица аргументов гипотетического закона движения, b – вектор его коэффициентов, `alpha in {psi, theta, gamma}` – вектор измерений угла ориентации.

Решаем систему `Ab=alpha` с помощью МНК:

`hatb = (A^TA)^-1A^Talpha,` (11)

тогда текущее отфильтрованное значение координаты α вычисляется как

`hatalpha_(m-1)=hatb_(0)+hatb_(1)sin(ct_(m-1))+hatb_(2)cos(ct_(m-1)).` (12)

При увеличении размера скользящего окна фильтра повышается плавность траектории, но происходит её рассогласование по времени по отношению к истинной. При уменьшении – наоборот, понижается плавность, но уходит рассогласование. Приемлемый результат даёт учёт ~50 кадров (m = 50) предыдущих измерений ориентации и ~100 кадров (n = 100) измерений положения. Вычислительная сложность алгоритма совмещения Наиболее вычислительно трудоёмкий этап предлагаемого алгоритма совмещения – поиск ТО на сенсорном изображении, соответствующих ТО на синтезированной проекции ВММ. Вычислительная трудоёмкость данного этапа зависит от числа N ТО на синтезированном изображении и оценивается в

`ulO(Na^2W^2)` (13)

арифметических операций умножения и сложения, где a2 – размер ТО, W2 (W > a) – размер областей поиска ТО на сенсорном изображении. Вычислительные эксперименты показали, что для качественного совмещения целесообразно иметь от 3 до 10 ТО (3 ≤ N ≤ 10). Сложность остальных этапов пренебрежимо мала, поэтому вычислительная сложность предлагаемого алгоритма совмещения также оценивается как (13).

В специальной книге, посвящённой вопросам совмещения изображений применительно к рассматриваемой области [13, с. 97], предлагается использовать двухэтапный поиск изображения искомой ТО на сенсорном изображении, что существенно сократило бы число вычислений. На первом этапе авторы предлагают производить грубый поиск минимума (в нашем случае по критерию (1)) с шагом h > 1 пикселя по каждой координате изображения, а на втором этапе (уточняющий поиск) с шагом в 1 пиксель в зоне ±h относительно координат оптимального значения критериальной функции. Однако результаты моделирования показали, что применение данного подхода существенно понижает вероятность нахождения искомых минимумов даже при минимальном значении h = 2, так как в силу требования к цветовой инвариантности входных разнородных сенсорных и синтезированных изображений приходится сопоставлять не сами изображения, а их контурные препараты (ИТО), см.: рис. 3, 4.

Без использования ресурсов видеокарты и распараллеливания выполнение алгоритма совмещения осуществляется со скоростью 6 – 7 кадров в секунду на процессоре Intel Core i7-4770 с тактовой частотой 3,4 ГГц на изображениях размером 640 х 480 пикселей при N = 10, a = 21, W = 61, что позволяет сделать вывод о возможности работы данного алгоритма в реальном масштабе времени (25 кадров в секунду) при использовании, например, специализированных видеопроцессоров, как это было сделано в работе [2]. Результаты компьютерного моделирования Предлагаемый алгоритм реализован в оконном приложении на языке C# с применением библиотеки OpenTK [18]. Реализация включает в себя моделирование функционирования бортовых СУВ, НС и ССВ.

Для формирования модельных сенсорных изображений от виртуальной одноканальной СУВ используется математическая модель, описывающая пошаговое преобразование спектрально-энергетических и пространственных признаков объектов наблюдаемой сцены в конечные яркости пикселей изображения в инфракрасном спектральном диапазоне (8-14 мкм) с учётом затухания э/м излучения в атмосфере в различных погодно-суточных условиях.

Ошибки НС нормально распределены с нулевыми математическими ожиданиями со среднеквадратическими отклонениями, равными 1° по углам ориентации, 10 м в плане и 20 м по высоте, что соответствует погрешностям реальных (бытовых) НС [6]. Размеры кадров 640 × 480 пикселей с полями зрения 40° × 30° соответствуют разрешению современных БОЭС видимого и ИК диапазонов, а частоты обновления изображений 25 Гц, координат положения 10 Гц и данных об ориентации 100 Гц – частотам выдачи данных реальными БОЭС и НС.

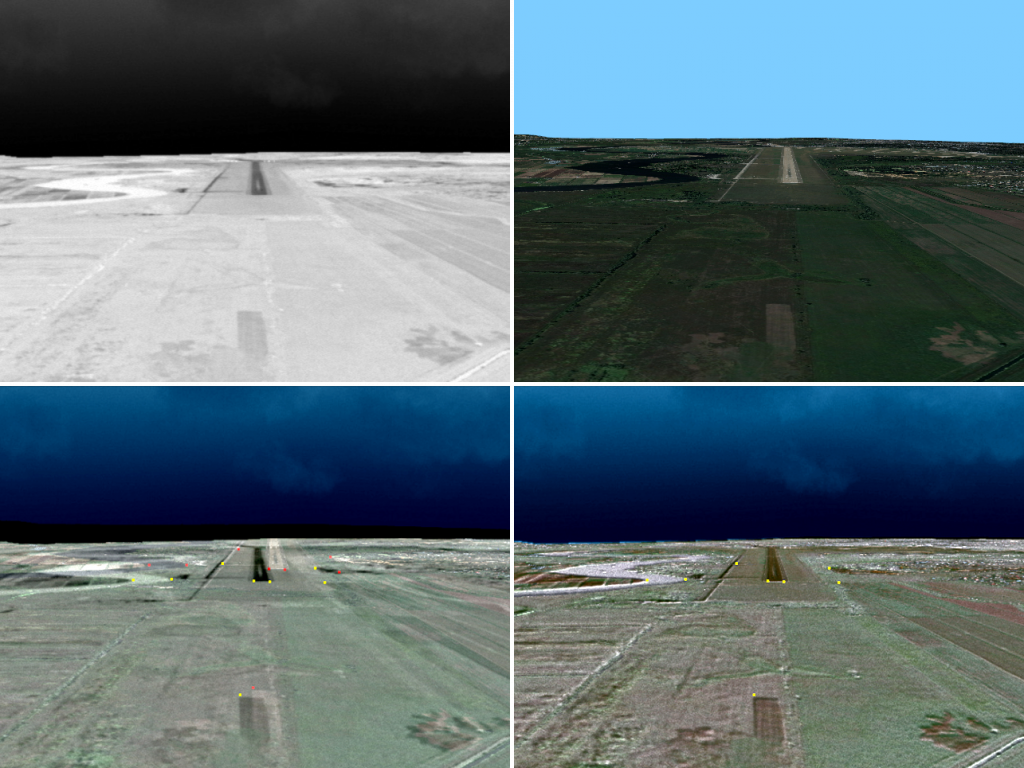

На рис. 4 изображены результаты работы с текстурированной ВММ при заходе самолёта на посадку при метеорологической дальности видимости (МДВ) > 10 км.

Рис. 4. Сверху слева – кадр СУВ; сверху справа – кадр ССВ; снизу слева – наложение изображений без совмещения; снизу справа – наложение изображений с совмещением. Точками выделены центры ТО, по которым выполняется совмещение

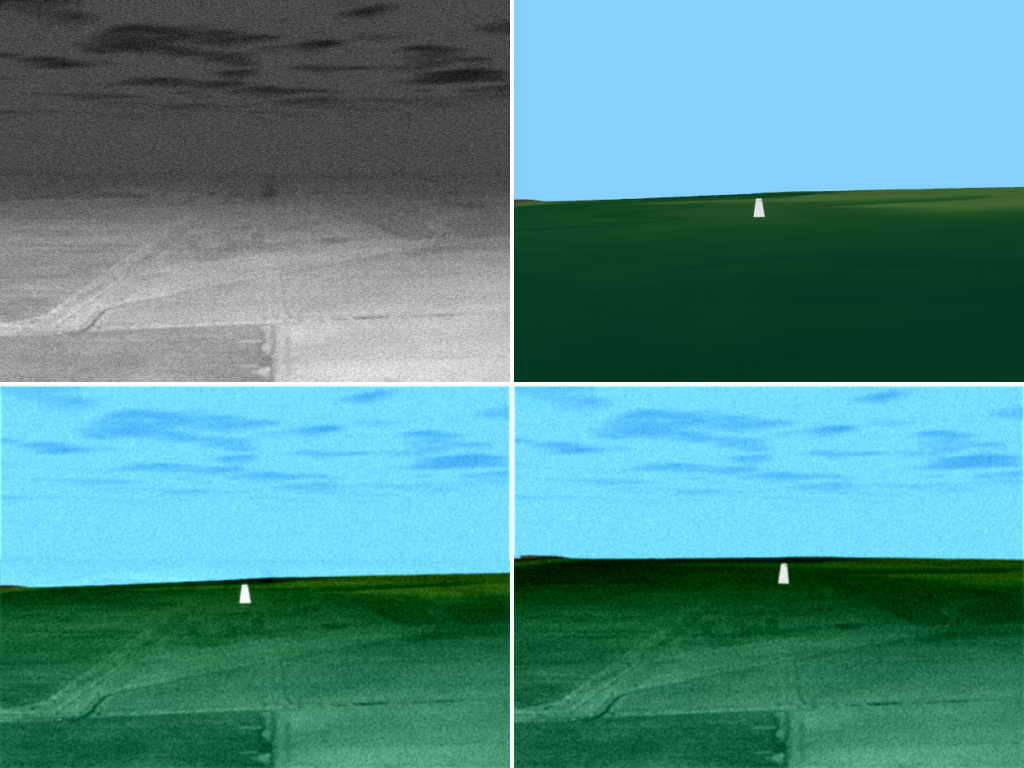

Нередко из-за недостаточной информативности изображений от СУВ (в силу погодных условий и/или низкой чувствительности фотоприёмников) или от ССВ (из-за отсутствия ТО для данной местности) невозможно установить их соответствие. В этом случае уточнение положения и ориентации производится только с применением фильтрации по Калману. Ситуация на рис. 5 соответствует МДВ 3 км и нижней границе облаков 500 м, а также ВММ без текстур.

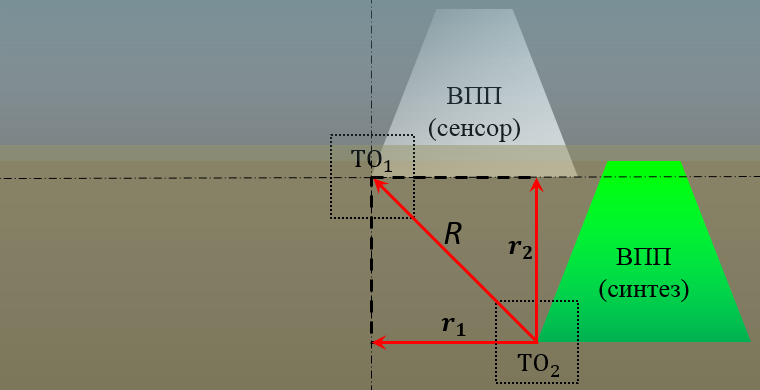

Рис. 5. Совмещение изображений при недостаточной информативности кадров СУВ и ССВ Оценка совмещения изображений в СКВ Качество работы любого метода совмещения изображений характеризуется мерой отклонения между соответствующими деталями совмещённых изображений, а также его устойчивостью во время работы. Принципиальный момент для разработки способа оценки качества совмещения – наличие определённых требований при его использовании для конкретных прикладных задач. В нашем случае требования определяются документами Р-315 и DO-315B.Эти документы регламентируют допустимую точность совмещения изображений для СКВ так, чтобы «величина отклонения в направлении расчётного взгляда пилота не превышала бы 5 мрад (5 мрад = `(180)/(pi)0.005~=0.286`°) как в горизонтальной, так и в вертикальной плоскости». Для используемых параметров СУВ и ССВ, формирующих изображения размером 640 × 480 пикселей с полями зрения 40° × 30°, допустимая величина расхождения R между соответствующими деталями по горизонтали r1 и вертикали r2 не должна превышать 4,576 пикселя в геометрическом центре изображения, см.: рис. 6.

Рис. 6. Оценка точности совмещения как максимально допустимого расстояния между соответствующими особенностями ТО1 и ТО2 на комбинированном изображении

Для указанных параметров СУВ и ССВ, оценка точности совмещения должна удовлетворять условию:

`R=sqrt(r_(1)^2+r_(2)^2)<=4.576sqrt(2)~= 6.5` пикселей. (14)

В окрестности геометрического центра изображения (в направлении расчётного взгляда пилота) величина отклонения между соответствующими ТО минимальна из-за минимальных искажений БОЭС и малости ошибок НС по сравнению с угловыми размерами совмещаемых изображений. Погрешности при создании ВММ считаются нулевыми, так как сенсорные и синтезированные изображения формируются по одной и той же модели. Поэтому для каждой пары совмещённых кадров будем оценивать минимальную величину расхождения между соответствующими особенностями.

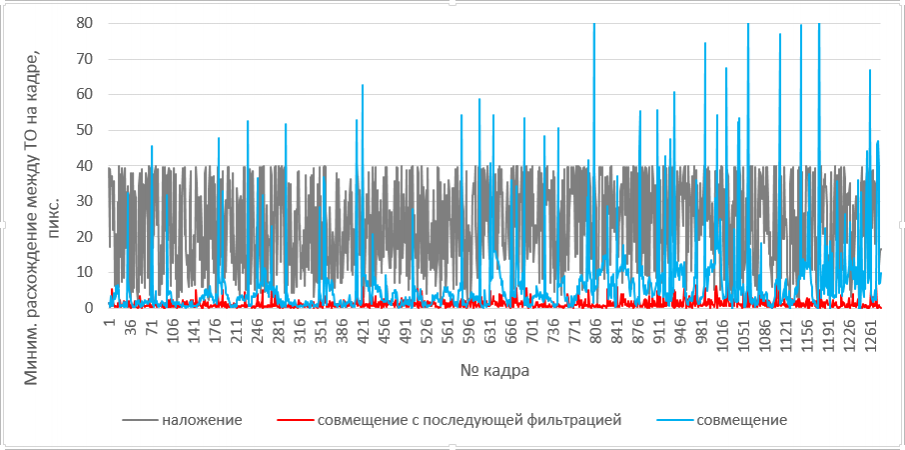

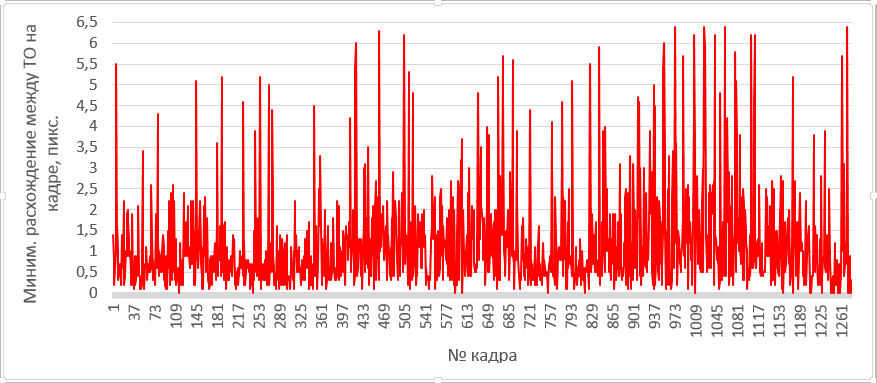

В соответствии с принятыми выше ошибками НС, оценим в динамике величину минимального расхождения между соответствующими особенностями (рис. 7) при наложении кадров без совмещения (серая линия), совмещении без фильтрации по Калману (голубая линия) и совмещении с последующей фильтрацией (красная линия).

Рис. 7. Результаты оценки качества совмещения в динамике при различных режимах совмещения

Из рис. 7 видно, что предлагаемый метод совмещения без фильтрации по Калману даёт сильные выбросы, связанные с ошибками распознавания ТО (голубая линия). Последующая же фильтрация по Калману уточнённых параметров внешнего ориентирования существенно сглаживает данные выбросы (красная линия):

Рис. 8. Результаты оценки качества совмещения в динамике при совмещении кадров с последующей фильтрацией

На рис. 8 максимальная ошибка совмещения в динамике не превышает 6,5 пикселей, что отвечает условию (14) и соответственно требованиям Р-315 и DO-315B по точности совмещения. Также из рисунка 8 следует, что необходимо делать вывод о качестве работы того или иного метода совмещения, исходя из наихудших его результатов в динамике на протяжении всего этапа полёта (проверка на устойчивость). Заключение Разработанный алгоритм совмещения сенсорных и синтезированных изображений в СКВ на основе топологической привязки и фильтрации по Калману обеспечивает достаточно точное и надёжное совмещение, удовлетворяющее требованиям Р-315 и DO‑315B, универсален и не требователен к сюжетному содержанию изображений, имеет низкую вычислительную сложность и может быть реализован на аппаратно-программной базе современной авионики. Рассматриваемый алгоритм проверялся на модельных данных. Тем не менее, при его проверке использовались точностные характеристики на уровне бытовых навигационных приборов, которые существенно уступают по точности современным авиационным НС, что также говорит о возможности использования такого алгоритма в недорогих и компактных пользовательских системах, а также в мобильных роботах. Тестирование и анализ работы алгоритмов на реальных данных планируется сделать в ходе будущих лётных экспериментов.

References

1. Bondarenko M. A. Sistema navigatsii mobil'noi tekhniki po global'noi trekhmernoi modeli mestnosti [Elektronnyi resurs] // Tekhnicheskoe zrenie. Vypusk 3(3), 2013. URL: http://magazine.technicalvision.ru/2013/12/ (data obrashcheniya: 10.01.2016)

2. Bondarenko A. V., Dokuchaev I. V., Yadchuk K. A., Bondarenko M. A., Drynkin N. V. Prostranstvenno-vremennaya fil'tratsiya dvizhushchikhsya izobrazhenii [Elektronnyi resurs] // Tekhnicheskoe zrenie. Vypusk. 1(5), 2014. URL: http://magazine.technicalvision.ru/spatio-temporal-filtering-of-moving-images/ (data obrashcheniya: 10.01.2016)

3. Vizil'ter Yu.V., Zheltov S.Yu. Problemy tekhnicheskogo zreniya v sovremennykh aviatsionnykh sistemakh // Trudy nauchno-tekhnicheskoi konferentsii-seminara “Tekhnicheskoe zrenie v sistemakh upravleniya mobil'nymi ob''ektami – 2010” / Pod red. R.R. Nazirova. – Vyp. 4 – M.: Universitet Knizhnyi Dom, 2011. – S. 11.

4. Zagoruiko S. N., Noskov V. P. Formirovanie 3D modeli vneshnei sredy s resheniem polnoi navigatsionnoi zadachi po posledovatel'nosti kompleksirovannykh izobrazhenii // Cbornik tezisov nauchno-tekhnicheskoi konferentsii “Tekhnicheskoe zrenie v sistemakh upravleniya - 2014” / Pod red. R.R. Nazirova, M.: Mekhanika. Upravlenie i informatika, 2014. – S. 50. [Elektronnyi resurs], URL: http://www.spsl.nsc.ru/FullText/konfe/TZSU_2014.pdf (data obrashcheniya: 20.09.2015).

5. German E. V. Algoritmy sovmeshcheniya raznorodnykh izobrazhenii v bortovykh sistemakh vizualizatsii [Elektronnyi resurs] // Ryazan', 2014. URL: rsreu.ru/en/component/docman/doc_download/4436-(data obrashcheniya: 22.03.2015).

6. Kostyashkin L. N, Loginov A. A., Nikiforov M. B. Problemnye aspekty sistemy kombinirovannogo videniya letatel'nykh apparatov // Izvestiya YuFU, 2013. – № 5 (142). - S. 61.

7. Lebedev M. A., Bondarenko M. A., Komarov D. V., Stepan'yants D. G., Vygolov O. V., Vizil'ter Yu. V., Zheltov S. Yu. Algoritm avtomaticheskogo sovmeshcheniya sensornoi i sinteziruemoi videoinformatsii dlya aviatsionnoi sistemy kombinirovannogo videniya // Vestnik komp'yuternykh i informatsionnykh tekhnologii, 2014. – № 7. – S. 8.

8. Putyak V. Preobrazovaniya koordinat i proektsii v OpenGL [Elektronnyi resurs] // 2005. URL: codingclub.net/Articles/OpenGL/Preobrazovaniyu_koordinat_i_proekcij_v_OpenGL (data obrashcheniya: 02.03.2014).

9. Metod naimen'shikh kvadratov [Elektronnyi resurs] // 2015. URL: ru.wikipedia.org/wiki/Metod_naimen'shikh_kvadratov (data obrashcheniya: 10.03.2015).

10. Metody nakhozhdeniya granits izobrazheniya [Elektronnyi resurs] // 2011. URL: habrahabr.ru/post/128753/ (data obrashcheniya: 02.02.2014).

11. Metod pokoordinatnogo spuska i ego skhodimost' [Elektronnyi resurs] // 2010. URL: machinelearning.ru/wiki/index.php?title=Metod_pokoordinatnogo_spuska (data obrashcheniya: 10.03.2015).

12. Metod deleniya otrezka popolam [Elektronnyi resurs] // 2011. URL: eco.sutd.ru/Study/Informat/mpd.html (data obrashcheniya: 11.03.2015).

13. Sovmeshchenie izobrazhenii v korrelyatsionno-ekstremal'nykh navigatsionnykh sistemakh / Pod red. L.N. Kostyashkina, M.B. Nikiforova. – M.: Radiotekhnika, 2015. – S. 208.

14. Rukovodstvo R-315 «Po minimal'nym standartam kharakteristik aviatsionnykh sistem (MASPS) dlya sistem uluchshennogo videniya, sistem iskusstvennogo videniya, kombinirovannykh sistem iskusstvennogo videniya i bortovykh sistem uvelicheniya dal'nosti videniya» Aviatsionnogo Registra Mezhgosudarstvennogo Aviatsionnogo Komiteta (AR MAK), 2012. – 86 s.

15. Fil'tr Kalmana [Elektronnyi resurs] // 2013. URL: habrahabr.ru/post/166693/ (data obrashcheniya: 15.05.2015).

16. Fusion of sensor data and synthetic data to form an integrated image, US 7925117 B2 [Elektronnyi resurs] // 2006. URL: google.com.ar/patents/US7925117 (data obrashcheniya: 13.02.2014).

17. Open Toolkit Library [Elektronnyi resurs] // 2015. URL: opentk.com (data obrashcheniya: 09.02.2015).

18. RTCA DO-315B Minimum Aviation System Performance Standards (MASPS) for Enhanced Vision Systems, Synthetic Vision Systems, Combined Vision Systems and Enhanced Flight Vision Systems [Elektronnyi resurs] // 2011. – 142 p. URL: https://www.eurocae.net/eshop/catalog/product_info.php?products_id=299 (data obrashcheniya: 10.01.2016).

Link to this article

You can simply select and copy link from below text field.

|